High Dynamic Range (HDR) ist gerade DAS Verkaufsargument für Fernseher und somit Streaming-Dienste wie Netflix und Konsolen wie der PlayStation 4 und Xbox One S. Leider kennen viele den Unterschied zu dem selben Begriff aus der Fotografie nicht.

High Dynamic Range: Aufnahme VS. Anzeige

Manche kennen den Begriff HDR vielleicht aus der Aufnahme von Bildern, der Fotografie und verwechseln dies mit der Anzeige von Bildern in HDR. Obwohl beide Technologien als Ziel eine realistischere Bildwiedergabe zu ermöglichen, sind sie dennoch unterschiedlich und haben wenig miteinander zu tun.

HDR für Fernseher ist ein Prozess zur Anzeige von Bildern. Dabei werden spezielle HDR-Inhalte vom Fernseher erkannt und auf eine Art und Weise dargestellt, wie es „herkömmliche“ SDR-Fernseher nicht können.

HDR für Kameras ist ein Aufnahmeprozess. Hierbei werden mehrere Fotos mit unterschiedlichen Belichtungszeiten aufgenommen und zusammengeführt. Dies erzeugt einen Effekt, der mehr oder weniger so aussieht, wie unser menschliches Auge die Szene ebenfalls sehen wahrnehmen würde. Jedenfalls besser, als eine einzelne Belichtungszeit dies könnte.

HDR in der Fotografie

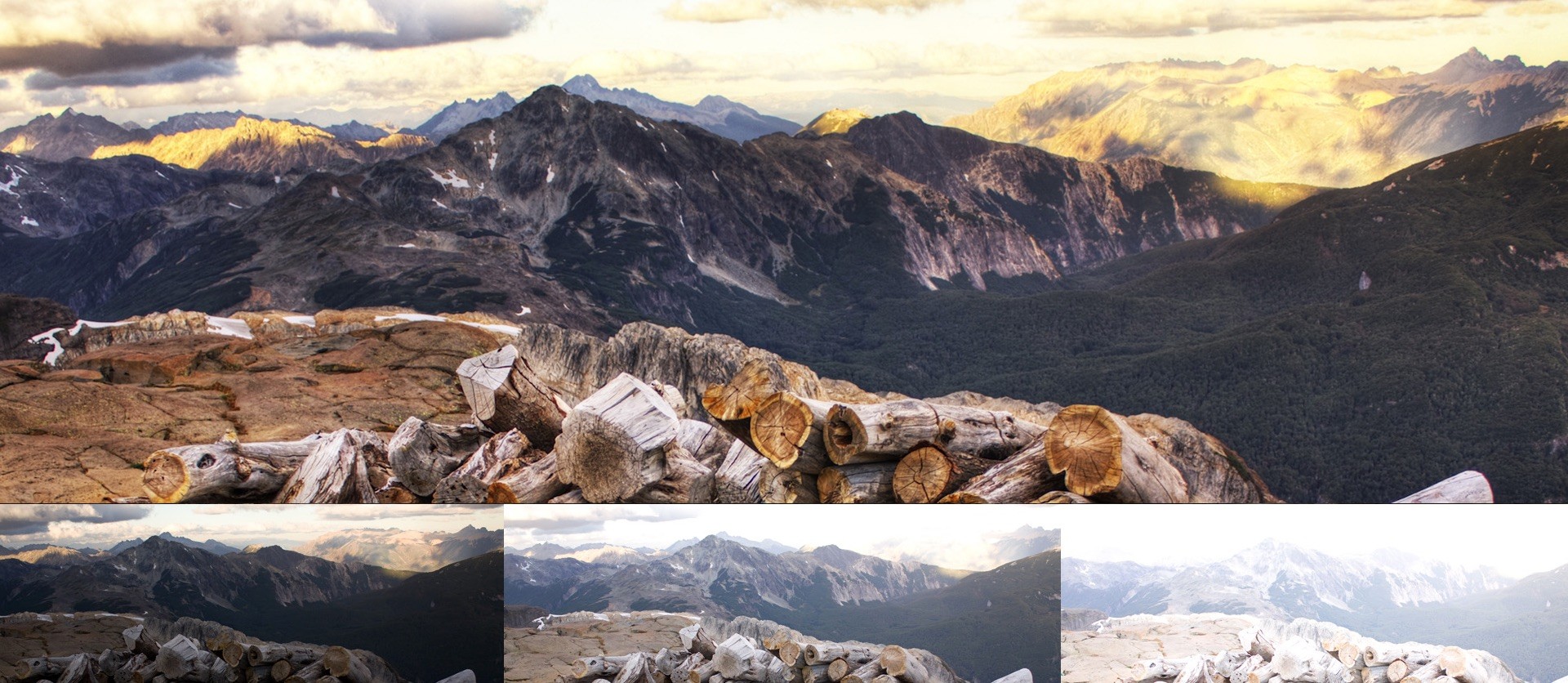

In den richtigen Händen können High Dynamic Range-Bilder richtig toll aussehen. Denn die Kombination der idealen Belichtungszeiten für sehr dunkle und sehr helle Bereiche kann die Details in den Schatten eines Bilder aber auch die Details in den Wolken gut herausbringen. Mittlerweile hat jedes durchschnittliche Smartphone eine solche Option, um Fotos im Nachhinein besser aussehen zu lassen.

Oftmals sehen diese Bilder kitschig aus, weil die Fotografen es übertrieben haben. Grelle Farben lassen Szenen so aussehen, als ob die Objekte und Wände selber Licht ausstrahlen würden.

HDR für Fernseher

Gute Fernseher mit High Dynamic Range verfügen über eine sehr starke maximale Helligkeit. Dies erlaubt dem Fernseher Inhalte mit einem hohen Kontrast zwischen Hell und Dunkel und mehr Farbnuancen darzustellen.

Das Bild oben von Horizon Zero Dawn zeigt dies ganz gut: Die grelle Sonne am Himmel blendet den Zuschauer bzw. Spieler regelrecht während man immer noch unten links Details in den Schatten ausmachen kann. Die Wirkung ist ein realistisches Bild ohne grelle Farben mit einem hohen Kontrast. Ebenso unterstützen The Witness, Wipeout Omega, Nex Machina und Uncharted 4 als auch Uncharted – Lost Legacy High Dynamic Range.

Formate für HDR sind HDR10 und Dolby Vision. Dabei wird HDR10 von allen Geräten unterstützt und wenige Geräte können beide Formate verarbeiten und darstellen.

High Dynamic Range bei Mediamarkt und Saturn

Bei Saturn und Mediamarkt werden oftmals Demos auf den (günstigeren) Fernsehgeräten gezeigt, welche das Bild in zwei Bereiche aufteilt: Grelle Farben und ausgewaschene Farben und schreibt dann High Dynamic Range-Effekt dran. Hierbei wird nichts weiter gemacht, als auf der bunten Seite den Helligkeitswert auf das Maximum zu setzen.

Bright things can be really bright, dark things can be really dark, and details can be seen in both.

nvidia über HDR Rendering

Ist High Dynamic Range wichtiger als 4k?

Tatsächlich können die meisten neuen 4k Fernseher High Dynamic Range darstellen. Wie gut oder wie schlecht hat in erster Linie mit der Helligkeit und der Qualität des Panels zu tun. Ein natives 10-Bit Panel (nicht mit HDR10 verwechseln!) um mehr Farbnuancen darzustellen sowie eine hohe maximale Helligkeit von mindestens 1.000 Nit. Außerdem sollte der TV viele unterschiedliche Helligkeitszonen bestehend aus LEDs besitzen. Bei dem teureren OLED leuchten die Pixel selber und werden nicht von hinten angestrahlt.

Unterstützung von HDR am Spiele-PC

Half-Life Loast Coast hat 2005 bereits einen Modus namens HDR Rendering vorgestellt. Dabei ging es darum, den Effekt von Überstrahlung durch Sonne und Reflektionen auf die virtuelle Welt zu übertragen. Einen ähnlichen Effekt nutzen manche Rennspiele, wenn man aus dunklen Tunnel in die helle Sonne fährt und alles kurz weiß wird. Titel wie Oblivion nutzen „Bloom“ um helle Bereich zu überstrahlen. Dies sind aber nur Effekte und haben nichts mit der Ausgabe von mehr Farben oder mehr Kontrastbereichen zu tun.

High Dynamic Range ist mehr als nur 10 bit Farbpräzision für Y,U und V (30 Bit Farbtiefe). Die meisten PC-Monitore sind wahrscheinlich für sRGB oder AdobeRGB kalibriert. HDR fügt dem System ein neues Kalibrierungsziel hinzu, welches ein „breiteres“ Farbspektrum bedeutet. Erst seit 2015 unterstützt HDMI 2.0a die Bandbreite für HDR.

Es gibt für professionelle Anwendungen für den PC Monitore mit nativem 10 Bit Panels. Diese können zwar die Farbtiefe aber nicht die Kontrastverhältnisse für HDR darstellen. Das heißt, Farbverläufe konnten besser dargestellt werden aber dadurch wird der Sonnenaufgang in Spielen nicht eindrucksvoller. Und das liegt nicht daran, dass nur ein Bruchteil der Monitore am PC über ein natives 10 Bit Panel verfügen.

Die Softwareunterstützung in Spielen, in den Windows-APIs und den Treibern der Grafikkartenhersteller hat bislang diese Technologie am PC nicht für nutzbar gemacht. Alien Isolation ist eines der ganz wenigen Titel der aktuellen Zeit, welches 10 Bit „Deep Color“ überhaupt unterstützt. Echtes High Dynamic Range mit Kontrastinformationen und Deep Color wird nun am PC durch drei Dinge ausgebremst: Unterstützung in Spielen, Monitoren mit HDR-Unterstützung und fehlende stabile Treiber.

Welchen Fernseher soll ich mir für High Dynamic Range kaufen?

Ich habe mich nach langer Recherche für den Samsung UE65KS7090 (kaufen) entschieden. Andere haben sich den Samsung UE65MU8009 gekauft.

Schreibe einen Kommentar